脳科学者の茂木健一郎氏(ソニーコンピュータサイエンス研究所 シニアリサーチャー)が、放送メディアの人工知能AI(Artificial Intelligence)活用の最前線に迫るシリーズ企画“メディアAI探訪”。第2回は、音声合成技術を深堀りします。最先端の技術に触れて、その実力に舌を巻いた茂木さんからは、様々な実用化のアイデアが飛び出しました。

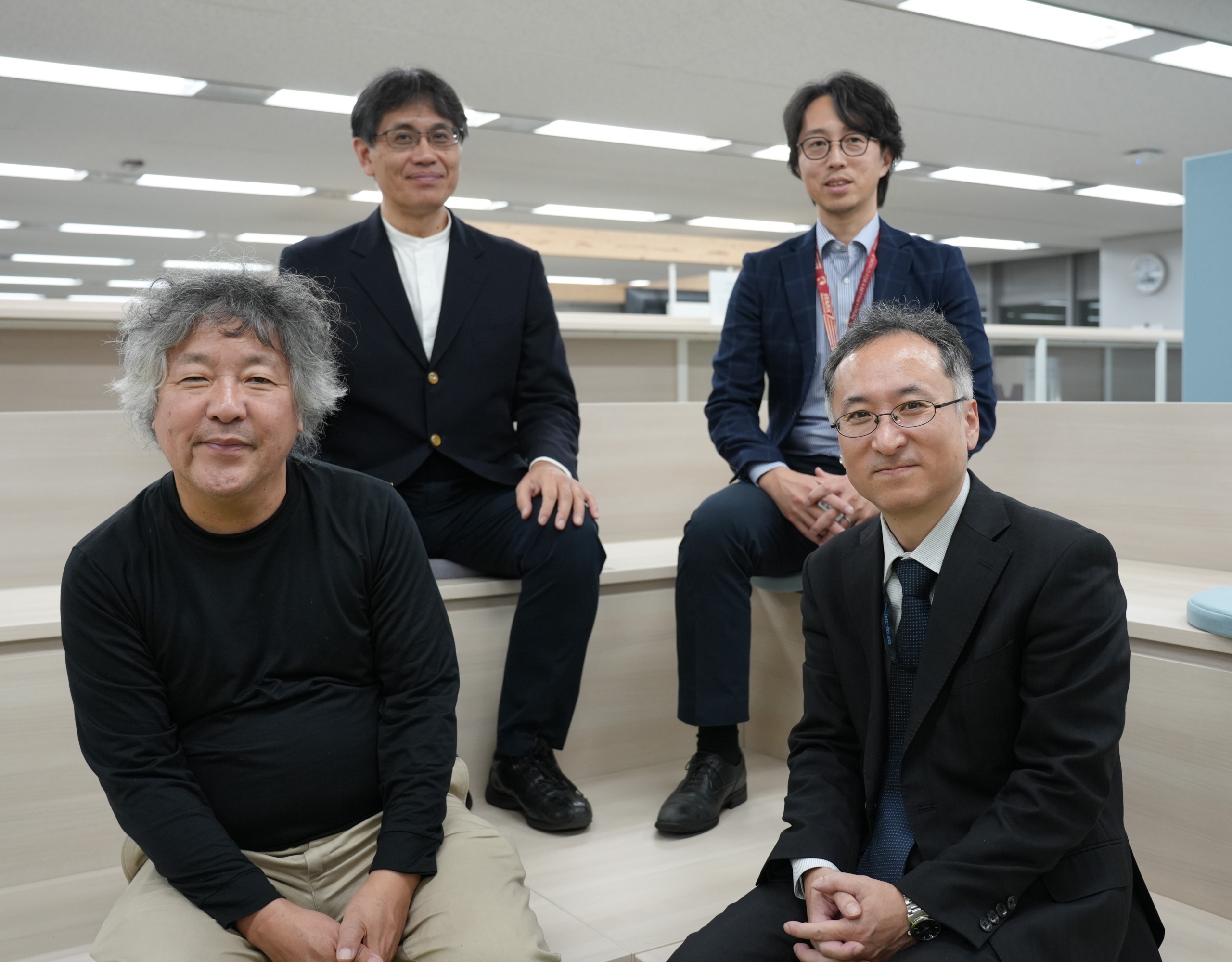

案内役は前回に引き続き、NHK放送技術研究所(以下、NHK技研)のAIエキスパート・河合吉彦シニア・リード、そしてNHK財団で音声合成技術の実用化に携わる今井篤上級研究員と、田澤直幸チーフエンジニアです。

聞き手もあざむく?! 最新の音声合成技術

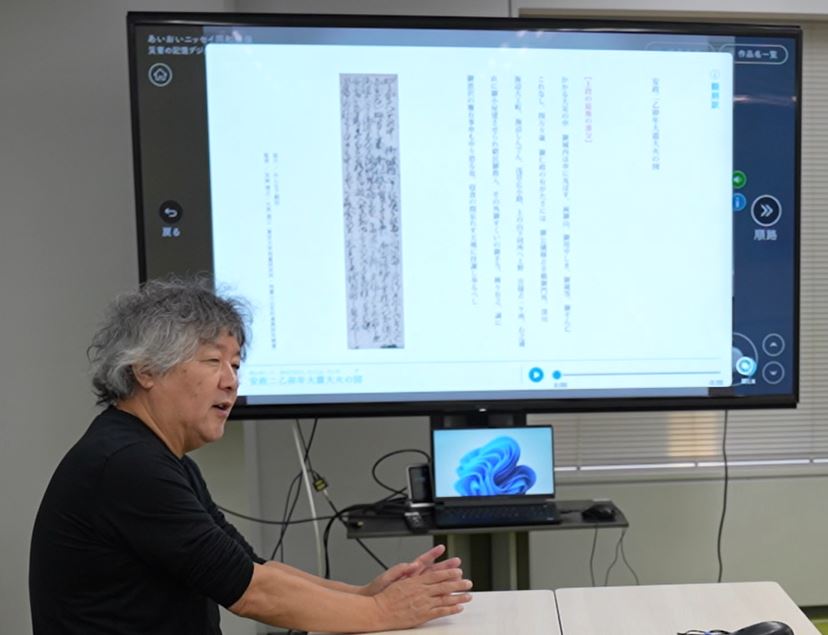

初めに、茂木さんに“ある音声”をお聞きいただきました。このステラnetでも何度かご紹介している「バーチャルミュージアム」の作品紹介(もちろん合成音声)です。

【バーチャルミュージアムの紹介(合成音声)】

※解説音声資料協力:あいおいニッセイ同和損害保険株式会社

茂木:えっ、これ、合成音声ですか?嘘でしょ!!

今井:驚かれましたね~(笑)実は NHK アナウンサーの発話を AI で学習した合成音声です。

茂木:そうとは知らず、どこかで聞いた事がある声だなぁ、と思って聞いていました。

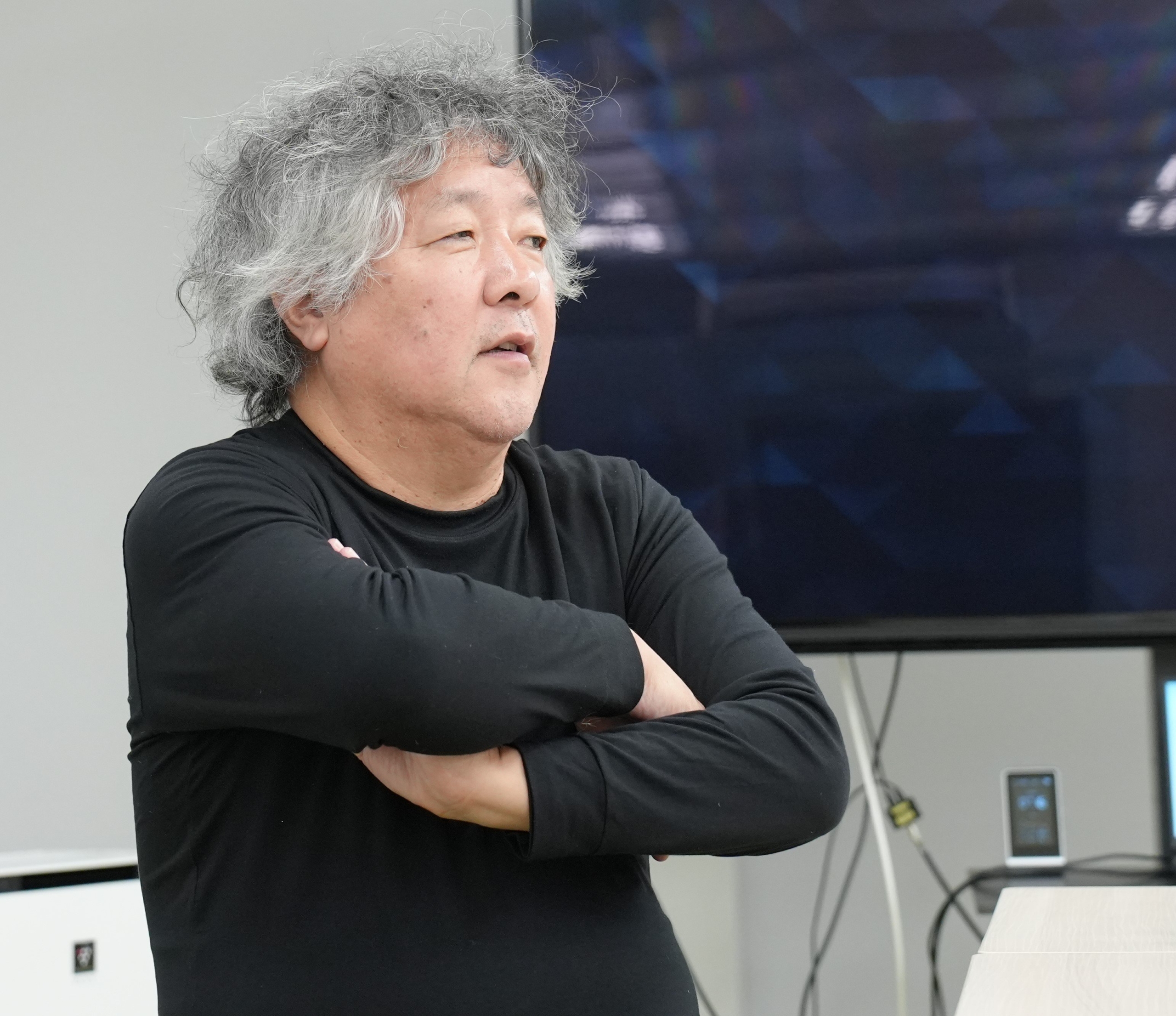

河合吉彦シニア・リード

茂木さんの反応に満面の笑み

茂木:NHKのニュースを見ているとAIによる合成音声に「おことわり」を入れていますが、何か、ことわる理由があるのですか?

今井:品質の問題です。人の発話ほどにはレベルが達していないんです。今日のアナウンサーは調子が悪いのかな、という誤解があってもいけませんので、おことわりを入れています。

茂木:なるほど、フェイクなど、倫理上の対策ではないということですね。

今井:ほかに、合成音声を用いたサービスとしては、オリンピックなどの国際的な大型スポーツ番組で“ロボット実況”を行いました。「誰が、いつ、どうした」といったリアルタイム競技データから実況調の文章を自動で生成して、これを合成音声で読み上げるサービスです。放送枠に入らなかった競技を対象に、ハイブリッドキャストとインターネットで配信しました。

またNHK財団では、放送用途に限らず、先ほどお聞きいただいたバーチャルミュージアムのようなものにもAI合成音声を利用したサービスを提供しています。

茂木:ここまでできているのは素晴らしいと思います。講演のスポークンワードは意外と難しいですが、かなりマーケットはありますよ。電子ブックを聞きながらランニングしている、という人もいますしね。

茂木:実際に合成音声の発話に協力したアナウンサーから抵抗とかなかったですか?

今井:今回の開発プロジェクトのメンバーはそんなに抵抗はなかったですね。

AIをうまく使ってルーティンワークを減らして、その分、人間らしい仕事にフォーカスするという考えも定着し、今は積極的に使う方向です。

茂木:収録して作り込んでいくもの、例えばスポーツでも、ダイジェストなどは合成音声でも良いのかもしれない。リアクション無しで淡々と進むものなどに適正ジャンルがありそうです。

河合:サッカーの実況などは、その場のリアクションなんかあるので難しいかもしれませんね。

茂木:さすがに❝真夏の大冒険!!❞(※)的な名言は合成音声では生まれないでしょうね(笑)

(※)東京 2020 オリンピックのスケートボード女子ストリート決勝で金メダルを獲得した 13 歳西矢椛選手が、5回目の「トリック」を決めた瞬間に実況アナウンサーが言った

聞き取りやすさはアクセント次第

日本語の音声で重要なのは「高低アクセント」。NHK放送文化研究所で発行している「NHK日本語発音アクセント新辞典」は、共通語アクセントのある程度の基準を示しているもので、NHKアナウンサーの話す言葉はこの辞典に準じています。

例えば共通語で「はし」は「箸」「端」「橋」で、それぞれアクセントが違うことは良く知られた話です。しかし関西弁ではアクセントが逆になることもあります。

茂木:日本で近代国家が形成される時に、国家統合の意味から、話し言葉が標準化されるのは非常に大事だったと思うけど、例えば関西と関東で違うし、当然東北では違うから、そこをどう扱うかって意外と本当はややっこしいですよね?

今井:いいご指摘ですね。実はそういうものが地方の放送局ではそれぞれに受け継がれています。特に地名。

田澤:天気予報などで登場する地名はその土地のアクセントがあったりして、東京でアナウンサーが共通語で読むのとはちょっと違ったりします。ですから「これ、どうだろう?」と思う時は現地局の方に電話して聞いたりしますね。

茂木:面白いですね。人間の認知っていうのは曖昧なものがあって、なぁなぁで済んでいたものが、AI になるとちゃんとインストラクションしないといけないって事になって、明示化される訳ですよね。ややっこしいですねえ~。

田澤:現場でアクセント事典を手元に置いてみながら収録をしたりするけれども、その場で「こうして書かれているけれども、最近はこう読んでいるよね」といった事はよくあります。アクセント事典は神様のように考えがちですが、言葉は時代で変わってきてしまうので、定型化するのは難しいのだろうと思います。

田澤:これが番組制作で使っているものと同等の機能を持ったものです。

まずテキスト文を貼り付けてスタート。始めに言語解析をします。ここでは、辞書にある単語とのマッチングをとっています。アクセントの上げ下げと、ポーズ(読みを止める)は手動で調整できます。自動でもある程度は読んでくれますが、気になるところも出てくるので、そんな箇所は手動で調整します。

茂木: 面白いなぁ、発話で上げ下げを意識した事はなかったのですけど、どういう法則があるのですか?例えば、文頭でどういう事をやって、次はこうするとかあるのかな?

田澤:まず、一文節にアクセントが1つ入ります。

茂木:日本語の場合、そうなんだ!でも、方言によって語尾が違うものもありますよね?

田澤:あります。地方によっては方言で語尾が上がったり下がったりするので修正します。

茂木:昔、合成音声が機械的に聞こえたのは、アクセントがなかったからなんだよね。でも脳内の処理として、何でこうなっていると聞きやすいのかなぁ???

今井:語の塊、チャンクとか言われますが、頭の中で明示させる塊があるとは言われています。客観的な分析では、大事なところを発話しようとしているときには、語気が強くなったり、ゆっくりと話したり……普段、人はそうやっているので、そこが反映されると聞きやすくなるのではないかと思います。

茂木:面白いなあ、ここにいる皆さんは、研究者でもあるし、普通の人に比べるとかなり敏感ですね。皆さんには絶対音感みたいな、絶対イントネーション感みたいなものありそうですね。

茂木:読んでもらうテキストは特別なものですか?

今井:色々な言葉が網羅されている文章と、単語の繫がりがうまくバランスされたバランス文、そういうものを使います。

茂木:現時点の学習は個別に学習していてチューニングするアプローチですね。パレットみたいに、男声とか女声、低い声と高い声、親しみのある声、冷静な声などの要素を可変すると、モルティングして(一気に固めて)、というやり方になるともっと汎用性が高まる気がしますね。

今井:そういう要素が沢山埋まってくれば、こういう声をこんな風に読ませたいといった、要望に合わせて発話を作ることはできるようになると思いますが、そこはこれからの課題です。

声の魅力ってなんだろう?

——音声合成システムの実力が見えてきた茂木さん。話は声の魅力へと展開しました。

茂木:やたらと音楽に詳しい高校生がいて、J-POPの新曲とBTS(韓国・K-POPのグループ)の曲、違いを解説してもらったんです。それが面白くて、BTSの曲は徹底的にトレーニングしないとあの歌い方は出来ないらしいです。我々が歌を聞いて上手いという事の意味は、素で上手いのではなくて、アスリートと同じように徹底的に訓練しないとあの領域に行けないらしいんですよ。

一方で、J-POPの場合は、どうもトレーニングして磨き上げた物よりも素の物を好む傾向があるらしく、国民性としてちょっと素人っぽい、ちょっと素人より上手い程度のものを好むらしいんですよ。それって、アナウンサーもある気がしていて、徹底的にトレーニングしたアナウンサーの世界、これはこれで凄いんだけど、なんかちょっと素人っぽいアナウンサーの世界とではどっちが視聴者が聴いてウケるのか、気になってきませんか?

今井:アスリート的にトレーニングした方かと言われると、必ずしも一致しない気がしますね。

田澤:NHK のアナウンサーは「お堅い」みたいなことをおっしゃる方がいると聞いたことはありますね。

茂木:そうなると、素人っぽい合成音声が好まれる要素があることになりますね。かなり昔の話ですがニュースセンター9時の女性キャスターも素人っぽさがウケてましたもんね(笑)。

河合:「下手ではないけれど素人っぽいとは何か?」が命題になりますね。

茂木:民放の番組では、方言も入れて、ありありと合成音声と分かるようなナレーションを入れて構成されている番組もありますけど、それがもう馴染んでしまって認知されるまでになっていますもんね。

茂木:声の魅力って、みんな簡単に言いますけど難しいですね。僕はラジオの仕事もしますけど、ラジオの人達は、聴いてすぐに“あの人だ”って分かるのは「いい声だ」って言いますね。でも、定義しようとすると難しくないですか?変な声ではないけど、魅力的、という言葉もしっくりこないし……ってこともありますよね。センサーがあると良いのだけれど。

今井:「モテ声」とか、「あの人に言われると説得力がある」とかと、同じような類かも知れませんね。アナウンサーの方々と話をしていると、その声で、内容の理解の深まり方が違う気がします。これが説得力に繋がるものかも知れません。1,2分では分からない事を持続的に聞ける声、というのもあるかもしれないですね。

茂木:山川静夫さんとか、加賀美幸子さんとか、NHKの名アナウンサーと言われる人がいらっしゃいますよね。あの人たちの共通点は何なんですかね?これは NHKでないと研究できませんね。

音声フィードバックの効用

——更に話題は音声のフィードバックへと進みました。

茂木:自分の声ってどれくらい聞かれます?僕の場合、一般向けに文章を大量に書くんですが、書いたらそれを音としてフィードバックしています。脳の学習として、将棋の感想戦みたいでいいんですよね。デバック(エラーやバグを見つけて修正)しているんだと思うと、重要な習慣のような気がしますね。気持ち悪いと思う人もいるかもしれないけど、冷静に自分のアウトプットが見えるんですよ。

田澤:学会前にやったことがあります。確かに効果はあると感じました。

今井:文書を読み上げさせたことで、気付かなかった間違いに気づくことはよくありますね。最終形ではなくて、そういったプロセスの途中段階で活用するという事ですね。

茂木:恐らくですが、かなり「聞き分け」の感受性は高いのでしょうね。我々よく、会話相手の声を聴いて「今日は調子悪いのかな?」とか、「落ち込んでるんじゃないかな?」、はたまた「この人、嘘ついてんじゃ……」とか、言うじゃないですか。ということは、脳の情報としてかなり閾値が細かく分かれている気がしますよね。

今井:認知科学的には聴覚の情報は視覚よりも何十倍、いや何百倍も多いので、そうなるように思います。

茂木:感情とかがあるので、音声のデータの方がテキストデータよりもはるかに情報量が多いわけです。生成系AIのChat GTPで使われるLLM(Large Language Model:大規模言語モデル)の音声版ができるといいですね。今のLLMはテキストデータだけですが、音声データを同様に徹底的に分析したら何が出てくると思いますか?

河合:それは未来のAI音声合成の土台になる可能性はありますね。具体的には、音声とテキストを一緒に学習するでしょうから、発音の意味も理解していくことになるでしょう。そうなると、今の合成音声制作システムにあるアクセント記号は不要になるかもしれませんね。

茂木:そこの分析はグランドチャレンジですね。面白い、音声は面白いなぁ。

——と、まだまだ、研究者同士のディープな話は尽きません。

次の可能性が見えた、かな?

AI 音声合成の未来

記事の最後に、今回も茂木さんの提案を2つ、ご紹介します。

ジェンダーニュートラルな声

難しいチャレンジかもしれませんが、今後はジェンダーニュートラルな声とか、必要かもしれませんね。ゴリラの研究をされている京都大学の山極壽一先生など、今、動物の言語に注目が集まっています。

ドリトル先生じゃないですけど猫がしゃべったらどうなるのとか、みんな気になると思うので、猫の声や犬の声のアナウンスを聞いてみたいなあ。科学的には人間が彼らの言語を理解していないだけという議論も出てきているので、やってもらいたいなぁ。「吾輩は猫である」の猫がしゃべったら、ジェンダー問題もなくて良さそうだし。

会議を面白くするロボット⁈

会話の中で話者交代が頻繁なほうが共同知能(コレクティブビンテージェンス)が高いといわれています。でも、大抵の会議って話者交代が上手くいっていないんです。そこをなにか、AI合成音声でアシストできないですかね。会話の中にAI合成音声の発話者が1人いて、いい感じで合いの手とか、途中までをサマライズ(要約)してくれるとかやってくれると面白いかなぁ。トーク番組でも音声合成機能のあるロボットが出演者の一人として対話に参加しているの、どうですか!!

第2回の探訪では、AIによる音声合成技術の最前線に迫りました。奥深いAI音声合成の世界を探訪した茂木さんは、NHK財団の技術のさらなる広がりに夢を馳せながら、今回の探訪を終えました。未来を託された河合さん、今井さん、田澤さん、責任重大ですね。

第3回では手話のコンピュータグラフィックスで活用されるAI技術を深堀りします。次回もお楽しみに!

今回探訪した AI による音声合成技術のお問い合わせ先↓

お問い合わせ:https://www.nhk-fdn.or.jp/es/contact/index.html

特許お問い合わせ: https://www.nhk-fdn.or.jp/es/transfer/contact.html

(NHK財団 社会貢献事業本部 石井 啓二)