人工知能 AI (Artificial Intelligence)が私たちの生活に浸透しつつあるいま、その活用は放送メディアのコンテンツ制作現場にも広がっています。その最前線を担っている現場の一つが NHK 放送技術研究所(以下、NHK 技研)です。NHK財団はその研究成果を活用して、社会の発展に寄与する事業を展開しています。

今回からスタートするシリーズ企画“メディア AI 探訪”では、脳科学者の茂木健一郎氏(ソニーコンピュータサイエンス研究所 シニアリサーチャー)が NHK 技研に潜入し、その技術の神髄に迫ります。

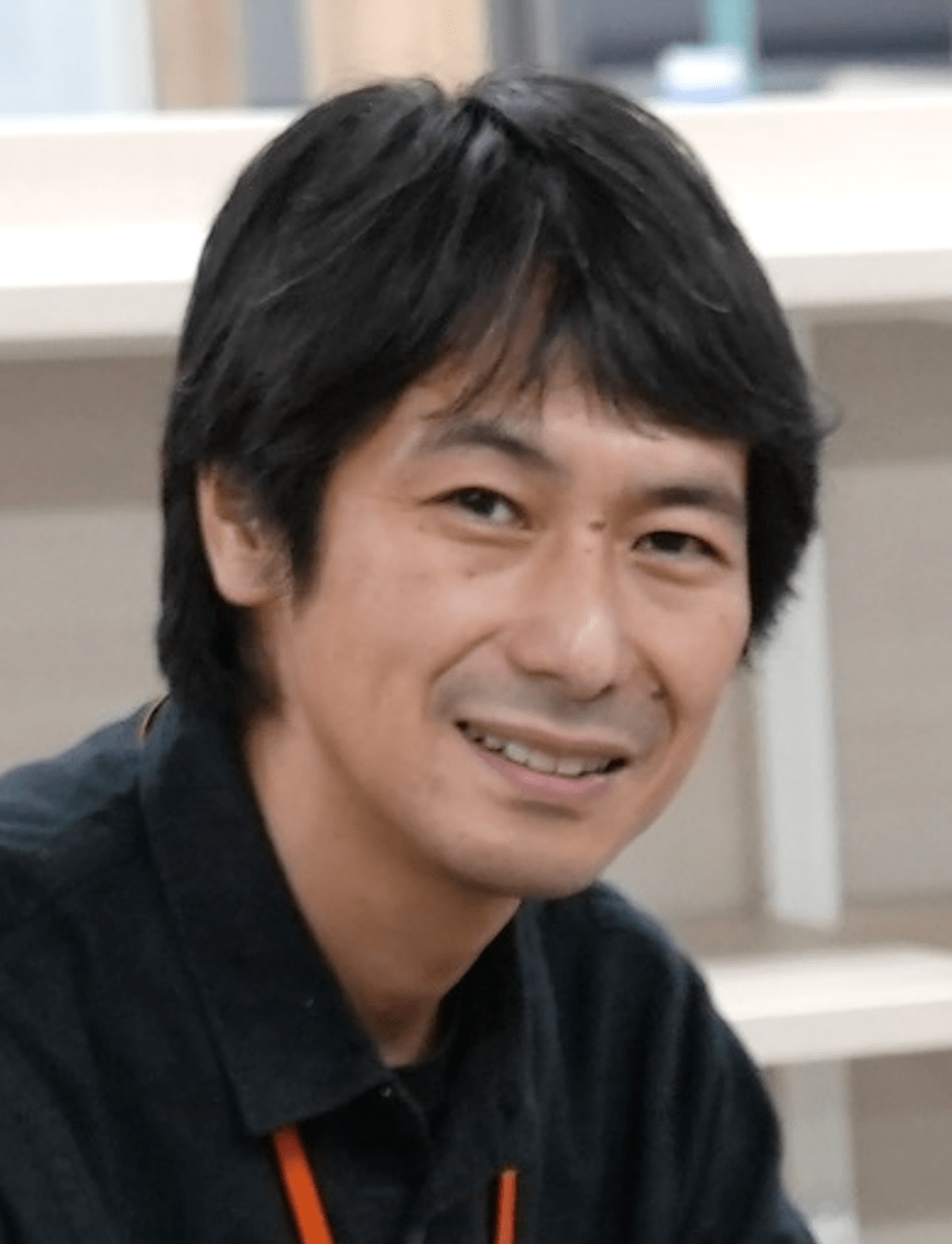

第1回は、技研のAIエキスパート・河合吉彦シニア・リードの案内で、番組コンテンツ制作を支援する技術、音声認識を深堀りします。

AIとNHK技研が描く2030-2040の未来図

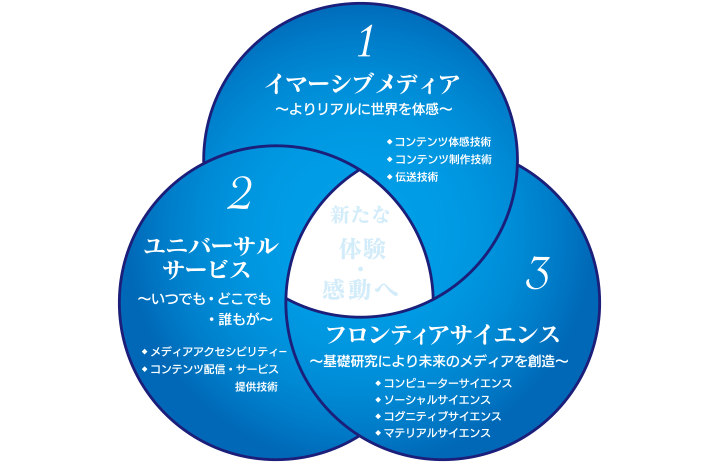

まず始めにファシリテーターの河合さんから、 NHK 技研が描く将来の放送メディアのあるべき姿「Future Vision 2030-2040」について、説明がありました。

2030-2040年に向けた放送メディアの未来ビジョン(NHK放送技術研究所)

研究開発の基本方針(NHK放送技術研究所)

河合:メディア AI の技術研究は、Future Vision の 3 本柱の1つであるフロンティアサイエンスの分野に入っています。具体的には画像処理や音声認識、言語処理などの技術です。また、3本柱の1つであるユニバーサルサービスの手話 CG(コンピューターグラフフィックス)なども挙げられます。

茂木:Future Visionに描かれる未来のお茶の間、こういう姿は今の時代だからこそ必要かもしれませんね。面白い。技研には過去に1度、お邪魔した記憶があります。技研の一般公開だったでしょうか。

茂木さんに技研訪問の記憶が少しずつ蘇ってきたところで、話は本題の音声認識に進みます。

ニュース生字幕を実現した災害報道への使命感

AIを使った音声認識技術を紹介するのは、NHK財団で実用化に携わる三島剛上級研究員です。

三島:「生字幕」という言葉を聞かれたことはありますか?

これは、原稿が字幕用にあるわけではなくて、アナウンサーの声をそのまま認識してリアルタイムに字幕を作る技術のことです。

茂木:これは、完全に自動で行われ、人の手は入らないのですか

三島:AI 技術を使って自動で発話を認識するのですが、やはり間違いもあります。このため、音声認識後に人が確認をして修正します。従って、厳密には修正時間分のディレイ(遅れ)があります。

茂木:人の確認作業が入るのは、ディレイがあっても、正確に伝える方が大事だという判断でしょうか?

三島:そうです。

河合:放送法上の決まりがあって、誤った字幕を出してしまうと訂正放送をしないといけません。

茂木:字幕文字も放送の一部ということですね。それならたびたび間違うわけには行きませんね。

三島:ニュースの生字幕がクローズアップされたのは、1999 年に東海村 JOC 臨界事故の災害報道がきっかけでした。当時はまだ、ニュースに生字幕は付加されていませんでした。

茂木:あのニュースは覚えています。たまたまだけど、見ていました。青い光(チェレンコフ光)が出たという事故ですね。

三島:この事故は午前に起こっていて、近隣に屋内退避勧告が出されて NHKもお昼のニュースで報道しています。ところが、事後の調査で当日の15時時点で健常者の8割以上がこの情報を把握していたのに対して、障がい者では4割程度に留まっていたことが分かりました。NHKではこのことを重く受け止め、ニュース報道の生字幕の実現を目指して、現場と技研が総力をあげて取り組むことになりました。

三島:その結果、NHKには人命に関わる情報をより多くの人に広く伝達する使命があるということで、世界に先駆けて2000年に音声認識技術によるニュース番組の生字幕放送を実現しました。

茂木:凄いなぁ、技研ビルの入り口にトロフィーがありましたけど、これもエミー賞候補ですね(笑)。字幕は障がい者向けと言われましたが、音声が聞き取りにくい高齢者や日本語を学んでいる外国人にとっても有用なツールだと思うなぁ。

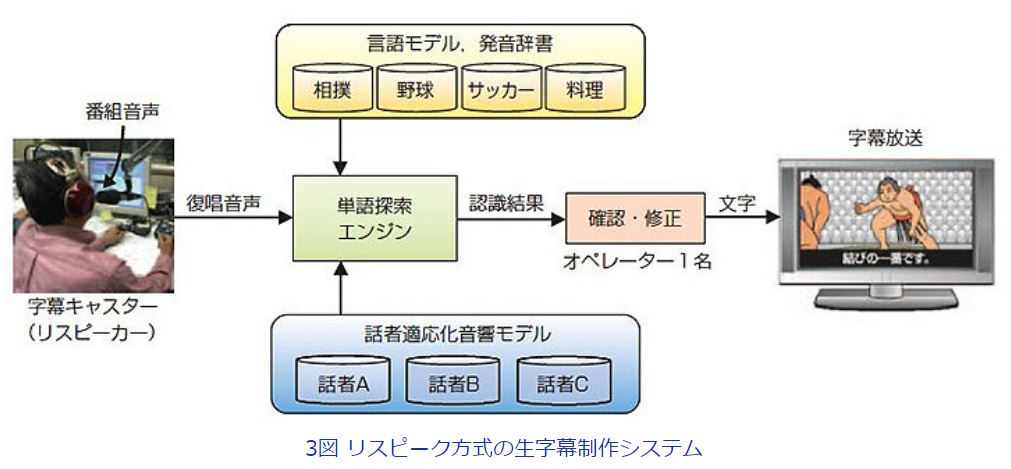

AI 生字幕をサポートするリスピークの妙技

生字幕制作にはいくつかの方式がありますが、AI による音声認識を効果的にサポートする手法に「リスピーク方式」があります。三島さんはその妙技を紹介します。

三島:生字幕のための音声認識では、放送音声を AI が直接認識するやり方と、専用の話者が話した声を認識するやり方があり、この 2 つをハイブリッドにやる方法もあります。

茂木さん:スタジオのアナウンサーの声を認識するのは一番やさしい気がしますが、街頭インタビューとか、スタジオのゲストでも滑舌が悪いと認識精度が落ちますよね?

三島:リアルタイムに認識して字幕を付与できる基準として認識率 95%程度を目標にしていますので、認識精度の高い話者が音声を読み直して(リスピーク)精度を上げる工夫もしています。

茂木:なるほど、賢いな! その手があったか! シャドーイングですね。

三島:はい、シャドーイングです。

茂木:ちなみにそのリスピークは誰がやっているのですか?

三島:当初はアナウンサーの方にお願いしていました。言い換えも大変お上手で滑舌も良いのでぴったりだったのですが、年月を経て、アナウンサー以外でも多少訓練すればできることが分かってきました。今は、認識誤りを修正する人がリスピークも同時にやる場合もあります。

茂木:修正する人が同時にやるのですか…、リスピークしながら修正する、というのはかなり忙しいですね。

三島:人間はやっぱり賢いもので、訓練するとこういったこともできるようになるんです。特にニュース番組にこのハイブリッド方式を使っています。

茂木:NHK の番組で、生字幕のカバー率は何%ですか?

三島:総務省の基準では、技術的に字幕を付与できる番組が指定されています。これに限れば、NHKの番組では100%となっています。技術的に難しいバラエティー番組や長時間に及ぶ国会中継などは対象から外れています。これらも含めた付与率は、88.9%(令和3年データ)になります。

茂木:ロードマップとしては 100%が最終目標ですか?

三島:そうなります。スポーツ番組や情報番組では、話者が絶叫(野球の「ホームラン!!」や相撲の「寄り切り!!」など)することも多いので、リスピーク方式のみで対応するケースもあります。

茂木:外国人のお名前など、固有名詞などは難しくないですか?

三島:人名などの固有名詞は難しいので、番組で出てきそうな固有名詞はできるだけ事前に学習して、なるべく認識精度が上がるように準備をしておきます。

リスピーク方式の妙技が茂木さんにも伝わり、認識率 95%を目指した生字幕制作現場の取組みをご理解いただけた様子です。話が弾む中、続けての紹介は音声認識のもう 1 つの応用事例、「字起こしシステム」です。

番組制作現場の声から働き方改革の担い手に

三島:番組取材の現場では、インタビューや記者会見など多くの音声を伴う重要な映像素材があります。こうした映像素材は、そのままだと一覧性に乏しく共有しづらいため、制作者は発話内容を必ず字起こしをしています。最終的にこれが視聴者に正確な情報を迅速に伝えることにつながるので、重要な作業ではあるのですが、発話を聞いて文字に起こすのは非常に大変です。そこで、この字起こしにAI音声認識を活用しようというものです。

茂木:番組制作者の実感がこもっていて面白いなぁ…。放送現場の皆さんも不便さに慣れているから、こういうツールがあると実は便利だということに気付かないこともあるのではないでしょうか?

河合:結構、現場からの要望と技研が取り組んでいることにギャップがあったりしますね。「こんなことできないか?」と言ってくることがとてつもなく難しかったり、反対に拍子抜けするほど簡単なことだったりしますね。

茂木:こうして考えると、技研の利点の1つは放送現場に近いから、リアルな声が届きやすい、これは大きな資産ですね。

河合:それはまさにその通りです。他の研究所との一番の違いはそこだと思います。

茂木:ラッシュ素材(未編集の映像素材)も全部文字起こしするのですか?

三島:最初は全部やります。制作者が自らやる場合、スタッフ総出でやる場合などいろいろありますが、コスト的にも時間的にも大きな作業量です。一方で、字起こしに作業に時間や労力が取られてしまい、番組制作の議論が削られてしまうと本末転倒なので、そういった課題の解決に貢献しています。

茂木:今の時代は、労務管理などについて外部からの指摘もあるので、ワークライフバランスの観点からも重要ですね。ここでの省力化という意味は大きい気がします。

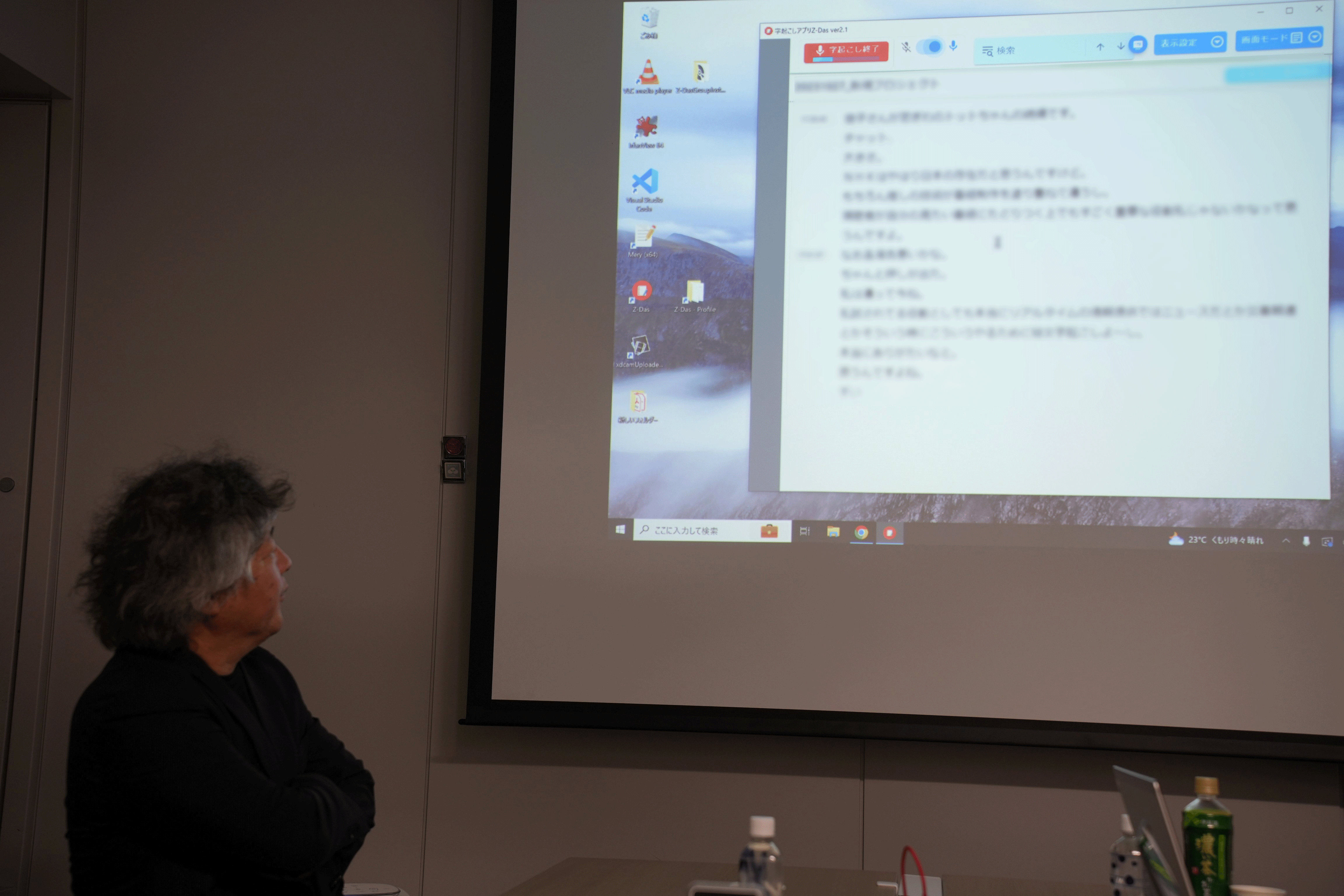

このあと茂木さんは、NHK 財団・西谷匡史副部長の案内で NHK や NHK の関連団体で使用する映像素材の字起こしシステムでリアルタイム音声認識を体験しました。

茂木:人の手による修正なしでも、これぐらいの認識ができるのは凄いなぁ。

西谷:このシステムはウェブブラウザ上で動作するようになっていて、音声認識結果を、動画を観ながら、複数人で修正して仕上げていくことができます。

茂木:ウィキペディア方式ですね。AIは100%ではないので、ラストワンマイル、最後の1%が大変ですよね。だから人力が速くなる。こうしてみると放送クオリティは、AIチェックの最終関門ですね。それと、認識結果をよく見てみると、話し言葉でよくある「あのー」や「えー」を自動で削除していますね?

西谷:はい、文脈から判断して、その程度はAIで削除できます。

三島:学習データに修正した字幕を使っているので、修正の段階で外すとその所作が音声認識として学習されています。その効果で削除できていると考えています。

茂木:そうなると「あのー」という話し言葉と、「あの山」「あの人」などといった「あの〇〇」とはきちんと区別ができている、ということですか?

河合:文章のつながりも観ているということですね。

茂木:一方、ドラマの中には削除できない「えーと」や「あのー」もありそうですね。中々奥深い世界ですね。あと、私の名前で言うと茂木(もぎ)と茂木(もてぎ)があったりしますがその辺りはどう判定しているのですか?

三島:新しい言語による学習は定期的にやっています。ニュースの場合は当日のニュース原稿を直前に学習しています。

茂木:世の中にはオタクの用語辞典みたいなものもあるので、新しい言葉も学習してほしいなぁ。最近だと「箱推し※」なんて新しい言葉も出てきていますし、言葉って生き物ですからね。

※アイドルグループなどで、個人でなく、グループ全体を「推す」こと

……などなど、茂木さんの好奇心はますます拡がり、参加者との会話は尽きません。

AI 音声認識の未来

探訪の最後に、AI音声認識技術の2つの代表的事例に触れた茂木さんから、いくつかの気付きや新たな展開について率直なご意見がありました。

茂木:生放送で見る必要があるニュース、報道、スポーツは放送の根幹ですよね。必然的に生字幕の重要性は高まります。お話を伺って、AI音声認識による字起こしが一番生きてくるのは、原稿をアナウンサーが読むケースではなくて、海外の BBC でもあるような報道記者が現場から直接リポートを届けるようなケースだな、と感じました。そうなってくると NHK のニュースがもっと新しくなる気がします。

NHK プラスで大相撲などをよく観る一視聴者としての願望ですが、1日の放送内容を一覧して見たいと思う時があります。NHKプラスに限らずですが、NHKのコンテンツに上手くたどり着く手段が少ないので、秀逸なコンテンツを逸失している気がします。字幕用に文字化された情報を検索にも使えると有効だと感じました。こうした文字情報は、災害情報など地域ごとに細かい情報も出せて、いろいろと可能性がありますね。

第1回の探訪では、AIによる音声認識技術の最前線に迫りました。

音声認識AI技術のメディア利用の現状を知った茂木さんからは、次の研究・開発へヒントも伺えた今回の探訪、現場の技術者にとっても意義ある機会となりました。第2回では音声合成技術を深堀りします。次回もお楽しみに!

今回探訪した AI による音声認識技術のお問い合わせ先↓

https://www.nhk-fdn.or.jp/es/contact/index.html

(NHK財団 社会貢献事業本部 石井 啓二)